W ciągu ostatnich kilku miesięcy społeczność sztucznej inteligencji została wstrząśnięta gorącą debatą wywołaną przez dwa wpływowe artykuły badawcze opublikowane przez Apple. Pierwszy z nich, " Illusion-of-thinking-the-debate-that-is-shaking-the-world-of-ai&_bhlid=a540c17e5de7c2723906dabd9b8f31cdf0c5bf18" target="_blank" id="">"GSM-Symbolic" (październik 2024), oraz drugi, "Iluzja myślenia" (czerwiec 2025 r.) zakwestionowały rzekome możliwości rozumowania dużych modeli językowych, wywołując mieszane reakcje w całej branży.

Jak już omówiliśmy w naszym poprzednim artykule „Iluzja postępu: symulowanie ogólnej sztucznej inteligencji bez jej osiągnięcia”, kwestia sztucznego rozumowania dotyka sedna tego, co uważamy za inteligencję w maszynach.

Badacze Apple przeprowadzili systematyczną analizę dużych modeli rozumowania (LRM) - modeli, które generują szczegółowe ślady rozumowania przed udzieleniem odpowiedzi. Wyniki były zaskakujące i dla wielu niepokojące.

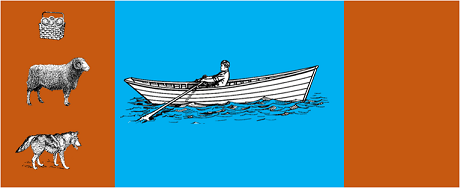

W badaniu poddano najbardziej zaawansowane modele klasycznym zagadkom algorytmicznym, takim jak:

Wyniki pokazały, że nawet niewielkie zmiany w sformułowaniu problemu prowadzą do znacznych różnic w wydajności, co sugeruje niepokojącą kruchość rozumowania. Jak donosi AppleInsider"wydajność wszystkich modeli spada, gdy zmieniane są tylko wartości liczbowe w pytaniach testowych GSM-Symbolic".

Na odpowiedź ze strony społeczności AI nie trzeba było długo czekać. Alex Lawsen z Open Philanthropy, we współpracy z Claude Opus z Anthropic, opublikował szczegółową odpowiedź zatytułowaną "Iluzja myślenia".kwestionując metodologię i wnioski z badania Apple.

Kiedy Lawsen powtórzył testy z alternatywną metodologią - prosząc modele o wygenerowanie funkcji rekurencyjnych zamiast wypisywania wszystkich ruchów - wyniki były diametralnie różne. Modele takie jak Claude, gemini i GPT poprawnie rozwiązały problemy typu Tower of Hanoi z 15 rekordami, znacznie przekraczając złożoność, w której Apple zgłosiło zero sukcesów.

Gary Marcuswieloletni krytyk umiejętności rozumowania LLM, przyjął odkrycia Apple jako potwierdzenie swojej 20-letniej tezy. Według Marcusa, LLM nadal zmagają się z "przesunięciem dystrybucji" - zdolnością do uogólniania poza dane treningowe - pozostając jednocześnie "dobrymi rozwiązywaczami problemów, które zostały już rozwiązane".

Dyskusja rozprzestrzeniła się również na wyspecjalizowane społeczności, takie jak LocalLlama na Redditgdzie deweloperzy i badacze debatują nad praktycznymi implikacjami dla modeli open-source i lokalnych wdrożeń.

Debata ta nie ma charakteru czysto akademickiego. Ma ona bezpośrednie implikacje dla:

Jak podkreślono w kilku spostrzeżeniach technicznychistnieje rosnące zapotrzebowanie na podejścia hybrydowe, które łączą:

Trywialny przykład: asystent AI pomagający w prowadzeniu księgowości. Model językowy rozumie, kiedy pytasz "ile wydałem na podróże w tym miesiącu?" i wyodrębnia odpowiednie parametry (kategoria: podróże, okres: ten miesiąc). Ale zapytanie SQL, które odpytuje bazę danych, oblicza sumę i sprawdza ograniczenia fiskalne? To robi deterministyczny kod, a nie model neuronowy.

Nie umknęło uwadze obserwatorów, że dokument Apple został opublikowany na krótko przed WWDC, co rodzi pytania o strategiczne motywacje. Jak wynika zanaliza przeprowadzona przez 9to5Mac"czas publikacji artykułu Apple - tuż przed WWDC - podniósł kilka brwi. Czy był to kamień milowy w badaniach, czy też strategiczne posunięcie mające na celu zmianę pozycji Apple w szerszym krajobrazie sztucznej inteligencji?".

Debata wywołana dokumentami Apple przypomina nam, że wciąż jesteśmy na wczesnym etapie rozumienia sztucznej inteligencji. Jak wskazaliśmy w naszym poprzednim artykulerozróżnienie między symulacją a autentycznym rozumowaniem pozostaje jednym z najbardziej złożonych wyzwań naszych czasów.

Prawdziwą lekcją nie jest to, czy LLM mogą "rozumować" w ludzkim tego słowa znaczeniu, ale raczej to, jak możemy budować systemy, które wykorzystują ich mocne strony, jednocześnie kompensując ich ograniczenia. W świecie, w którym sztuczna inteligencja już teraz przekształca całe sektory, pytanie nie brzmi już, czy te narzędzia są "inteligentne", ale jak z nich korzystać w sposób skuteczny i odpowiedzialny.

Przyszłość sztucznej inteligencji w przedsiębiorstwach prawdopodobnie nie będzie leżeć w jednym rewolucyjnym podejściu, ale w inteligentnej orkiestracji kilku uzupełniających się technologii. W tym scenariuszu zdolność do krytycznej i uczciwej oceny możliwości naszych narzędzi sama w sobie staje się przewagą konkurencyjną.

Najnowsze zmiany (styczeń 2026 r.)

OpenAI wprowadza na rynek o3 i o4-mini: 16 kwietnia 2025 r. firma OpenAI wprowadziła na rynek o3 i o4-mini, najbardziej zaawansowane modele rozumowania z serii o. Modele te mogą teraz korzystać z narzędzi w sposób agencyjny, łącząc wyszukiwanie w Internecie, analizę plików, rozumowanie wizualne i generowanie obrazów. o3 ustanowił nowe rekordy w testach porównawczych, takich jak Codeforces, SWE-bench i MMMU, natomiast o4-mini optymalizuje wydajność i koszty w przypadku zadań rozumowania o dużej objętości. Modele wykazują zdolność „myślenia obrazami”, wizualnie przekształcając treści w celu przeprowadzenia bardziej dogłębnej analizy.

DeepSeek-R1 wstrząsa branżą sztucznej inteligencji: W styczniu 2025 r. firma DeepSeek wypuściła R1, model wnioskowania typu open source, który osiągnął wydajność porównywalną z OpenAI o1, a koszt jego szkolenia wyniósł zaledwie 6 milionów dolarów (w porównaniu z setkami milionów dolarów w przypadku modeli zachodnich). DeepSeek-R1 pokazuje, że zdolności rozumowania można stymulować poprzez czyste uczenie się przez wzmocnienie, bez konieczności stosowania opatrzonych adnotacjami demonstracji ludzkich. Model stał się najpopularniejszą bezpłatną aplikacją w App Store i Google Play w kilkudziesięciu krajach. W styczniu 2026 r. DeepSeek opublikowało 60-stronicowy artykuł, w którym ujawnia sekrety szkolenia i szczerze przyznaje, że techniki takie jak Monte Carlo Tree Search (MCTS) nie sprawdziły się w przypadku ogólnego rozumowania.

Anthropic aktualizuje „Konstytucję” Claude'a: 22 stycznia 2026 r. firma Anthropic opublikowała nową, liczącą 23 000 słów konstytucję dla Claude'a, przechodząc od podejścia opartego na zasadach do podejścia opartego na zrozumieniu zasad etycznych. Dokument ten stał się pierwszym ramowym dokumentem dużej firmy zajmującej się sztuczną inteligencją, który formalnie uznaje możliwość świadomości lub statusu moralnego sztucznej inteligencji, stwierdzając, że Anthropic troszczy się o „dobrostan psychiczny, poczucie własnej tożsamości i dobre samopoczucie” Claude'a.

Debata nabiera tempa: w badaniu z lipca 2025 r. powtórzono i udoskonalono testy porównawcze Apple, potwierdzając, że LRM nadal wykazują ograniczenia poznawcze przy umiarkowanym wzroście złożoności (około 8 krążków w wieży Hanoi). Naukowcy wykazali, że nie wynika to wyłącznie z ograniczeń wydajnościowych, ale także z rzeczywistych ograniczeń poznawczych, podkreślając, że debata jest daleka od zakończenia.

Aby uzyskać wgląd w strategię AI Twojej organizacji i wdrożyć solidne rozwiązania, nasz zespół ekspertów jest dostępny na indywidualne konsultacje.